Pensieri lenti, veloci, esponenziali: l'AGI è davvero qui?

- Massimiliano Turazzini

- 9 feb

- Tempo di lettura: 8 min

Aggiornamento: 11 feb

La scorsa settimana il buon Alberto Romero ha scritto un bellissimo post che mi ha fatto molto riflettere intitolato "AGI Is Already Here—It’s Just Not Evenly Distributed". Con grande semplicità ha sintetizzato le opportunità che l'AI ci offre 'a diversi livelli di utilizzo'. Dopo aver letto il mio post, vi invito a dedicargli 10 minuti.

In sostanza dice che la crescita delle AI da sola è un vantaggio sufficiente a migliorare le nostre 'performance' con i nuovi modelli anche se non sappiamo scrivere prompt. Ma, quando sappiamo usarle (ovvero scrivere bene i prompt, comprendere come interagire bene con QUEL modello) possiamo elevare ancora di più, a parità di tecnologia, le nostre capacità.

Quell'articolo mi ha fatto molto ragionare, quindi provo a reinterpretarlo a modo mio raccontandovi le lampadine che mi ha acceso, perchè siamo come sempre davanti a qualcosa di molto, molto impattante.

Spoiler su entrambi: non si parla ancora di Intelligenza Artificiale Generale, ma dopo aver letto questo post capirete perchè viene citata sempre più spesso.

I miei pensieri in questo periodo

Sto condividendo tantissime informazioni, ne sto ricevendo ancora di più. Non c'è tregua nell'evoluzione dell'AI, e non c'è tempo per seguire tutto.E come dico sempre, non è un problema di tecnologia (che è sempre più complessa e difficile da capire) ma di impatto che questa sta avendo su tutto ciò che consideravamo normale.

Di base era normale che una persona si formasse nei primi anni della sua vita e continuasse ad apprendere successivamente, seguendo ritmi più o meno veloci, con qualche accelerazione qua e là fornita dalla scuola, dall'essersi trovato in ambienti giusti, dall'aver avuto la giusta attitudine e le intuizioni necessarie a migliorare le sue 'performance'. (Permettemi di usare 'performance' come termine riduttivo per evitare di parlare di intelligenza, per includere concetti di efficienza, soddisfazione nell'esecuzione, emozioni correlate, successo ecc.)

Poi, a un certo punto intorno al 2017, ho iniziato a conoscere e frequentare i primi Language Models e ho capito che il concetto di normale sarebbe cambiato in fretta. Ci ho scritto un romanzo che mi ha richiesto un'anno abbondante di lavoro: Glimpse: per dare un'occhiata a ciò che sarebbe potuto succedere con sistemi di AI in grado di capire, comprendere e rispondere di conseguenza a noi umani, a prescindere dalla tecnologia in sé. Non vi annoio con la mia storia recente ma, in questo viaggio con l'AI sto scoprendo più cose di quante riuscirò mai ad approfondire.

Ad esempio:

L'errore di delegare all'AI attività che potrebbero rivelarsi dannose per noi.

Dovremmo sempre migliorare dopo ogni interazione con un'AI. O direttamente (nuova conoscenza) o indirettamente (Risparmiando tempo su attività banali per fare qualcosa che ci dà più valore).

L'accelerazione è costante, con forti scossoni, che ci fanno abbandonare rapidamente la strada in cui eravamo per andare su una ancora più ripida.

L'AI è veloce ma noi abbiamo bisogno di tempo per assimilarla.

Non potremo mai imparare bene a fare tutto.

Ogni tre anni circa dovevo disimparare, ora probabilmente lo devo fare ogni tre mesi (Ad esempio prima di questo post sembrava avesse senso disimparare come fare un buon prompt, ma come capirete non è così)

Misuravo il tempo in quantità di volte in cui la tecnologia mi stupiva in un anno. Ora va di moda chiamarli "Aha moments", io li chiamavo 'eureka moments' ma avete capito di cosa parlo. Ci sono stati periodi dove la quantità per anno era zero. Recentemente sono arrivato anche a tre momenti di stupore alla settimana.

Un po' di "Aha moments"

Ci sono momenti nei quali la nostra consapevolezza aumenta e la nostra crescita lo fa di conseguenza, momenti in cui diventiamo consapevoli di un cambiamento prossimo o già avvenuto, e ci rendiamo conto che dovremo fare i conti con lui.

E uno di questi momenti si è realizzato leggendo il post di Alberto Romero che ha messo assieme una serie di altri "Aha Moments" che ho fatto negli scorsi anni e si sono meravigliosamente allineati nella mia testa che ormai sta esplodendo.

In ordine sparso:

Il libro "Exponential Organizations" di Salim Ismail

I primi LLM che iniziavano a rispondere cose sensate (GPT 3.0)

I primi LLM che iniziavano a comprendere richieste strutturate e molto complesse (GPT 4.0)

I primi modelli multimodali e tutta la serie di evoluzioni degli ultimi anni in modelli di diversi produttori

I primi LLM che iniziavano ad 'agire' con altro software (GPT4 con code interpreter)

Gli SLM 'distillati' (se non sapete cosa sono... qui in italiano e qui in inglese ve lo spiega velocemente ChatGPT)

Le scaling laws dell'AI, training, inferenza, reasoning (qua ci dovrò scrivere qualcosa di semplice, non delegherò a ChatGPT una risposta affrettata)

la comprensione del nostro ruolo quando ci relazioniamo ad un'AI (qui la visione iniziale di Ethan Mollick

Il concetto di delega strumentale e delega cognitiva, di cui parlo qui, (here in english )

Il concetto di Jolting Technology

I Reasoning Models (la serie O1, O3, Deepseek, Gemini Flash Thinking), i modelli che prima di rispondere pensano.

Agenti AI come Cline e Lovable che si occupano per me di sviluppare un software intero partendo da un'analisi e pochi prompt

I Reasoning Agents: modelli che oltre a pensare hanno a disposizione strumenti come racconto qui e qui in inglese

Veder interagire tra loro diversi agenti AI in sistemi agentici

Il gioco di 'scatole cinesi' di crescita esponenziale raccontato benissimo da Peter Gostev qui

e un sacco di altre informazioni interessanti studiate negli ultimi anni.

Lo so, sono un po' tanti come puntini. Ma il tema qui è proprio la complessità unita a un sacco di evoluzioni rapide che rendono complesso il trovare figure chiare unendo i puntini.

E vi confesso che nel mio attuale viaggio con l'AI ho spesso un sacco di dubbi e perplessità (non le voglio chiamare paure) su cosa impatterà, come impatterà, come ci adegueremo a questa velocità evolutiva?

Cosa accadrà quando renderemo normale la presenza dell'AI, che continuerà a crescere, nelle nostre vite. Far diventare normale la convivenza con l'AI significherà entrare in simbiosi? E cosa accadrà quando ci saranno molti scossoni, molti punti di discontinuità, quando, nel corso di questa simbiosi, uno dei due partner correrà ed evolverà troppo velocemente? Ma sto divagando, torniamo all'oggi.

L'Intelligenza Aumentata

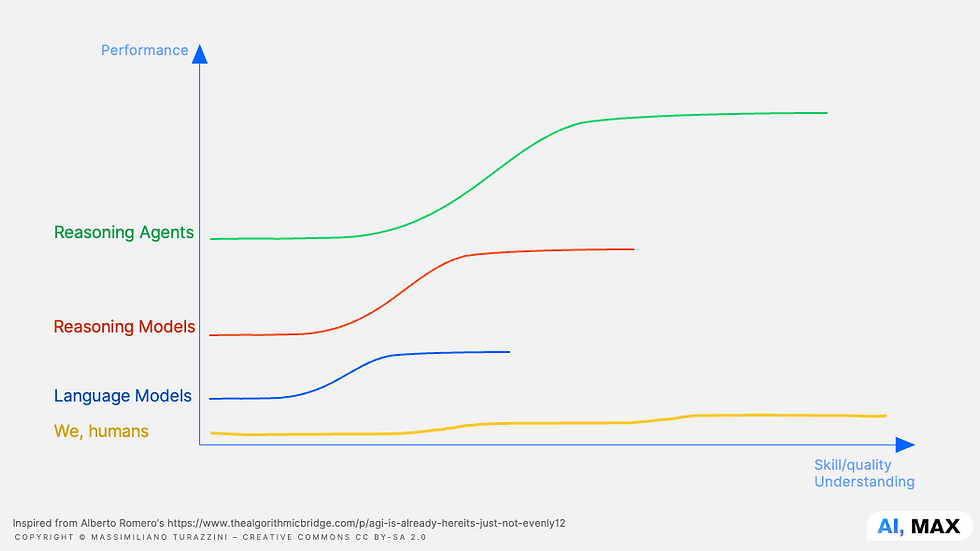

Chiedo scusa come sempre a tutti i grafici del mondo ma questa è la mia rappresentazione rivista e generalizzata del grafico di Alberto Romero.

Nel suo caso si parla specificatamente di skill di prompting e di alcuni modelli di OpenAI. Io provo a generalizzarlo.

Sull'asse X trovate quindi le nostre skill come umani, la qualità con cui ci esprimiamo e con cui sappiamo usare uno strumento, con cui comprendiamo.

Sull'asse Y le 'performance' come le ho raccontate all'inizio di questo post. Performance che possiamo misurare disponendo ora di una sorta di Intelligenza Amplificata (che mi piace molto di più di Artificiale). Di fatto l'AI funziona dove è un amplificatore delle nostre capacità.

Qui non trovate unità di misura e probabilmente le scale e le distanze sono diverse, ma ci interessa il concetto di distanza tra le varie curve (a me viene sempre un fremito quando si tratta di misurare numericamente una performance mentale).

Ho poi aggiunto la serie "noi umani" che, costantemente e inesorabilmente, miglioriamo nel tempo, sia come individui che come specie, seppur a velocità evoluzionistica, non certo esponenziale.

In pratica

Ma cosa accade quando iniziamo ad utilizzare un Language Model?

Non sapendolo usare (scrivendo male o a casaccio i prompt) ci permette un balzo in avanti nelle nostre performance perché il modello, in sé, aumenta le nostre possibilità di una performance migliore.

Se poi iniziamo a comprenderlo e saperlo usare (scrivendo prompt migliori) allora il salto qualitativo, a parità di modello, aumenta di molto.

I modelli di reasoning, di per sé, offrono un salto di qualità superiore rispetto a quello che otterrebbe chi ha una perfetta padronanza di un modello di base. In altre parole, anche se siete esperti nel prompting con GPT-4o, le capacità intrinseche di un modello di reasoning (come O1) superano quelle di un modello tradizionale, persino con un prompt semplice.

Il terzo stadio avviene con i Reasoning Agents, quando cioè diamo ai modelli di Reasoning degli strumenti (ad esempio la ricerca sul web, su knowledge base, su dati privati) e li lasciamo esplorare autonomamente le informazioni. Qui, per mantenere il controllo, i prompt diventano molto più complessi, ma se volete lasciarli fare (occhio) basta parlare loro come si farebbe con un apprendista.

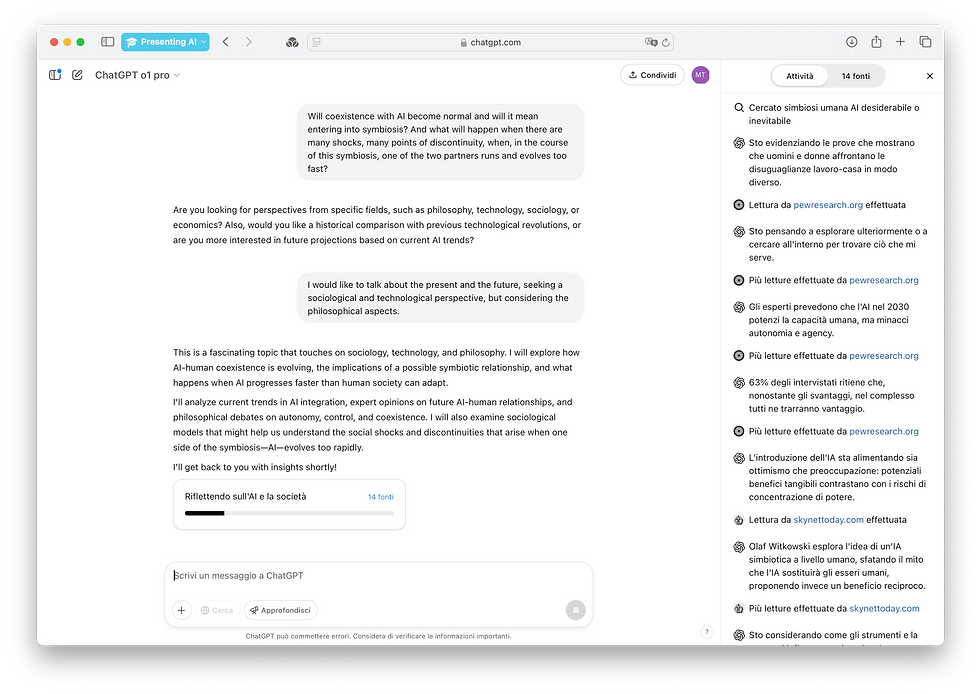

Ad esempio, provando la prima volta O1-Pro con DeepSearch, ho avuto uno dei più grandi Aha moments della mia vita...

Perchè? Leggete il prossimo paragrafo e analizzate bene bene l'immagine.

Qui ho semplicemente riportato il paragrafo sulla simbiosi scritto sopra, lasciando a 'lui' tutta la ricerca successiva. Vedere un agente AI che approfondisce concetti e si preoccupa di cercare informazioni, le legge una per una, adatta le sue strategie successive a quanto ha appreso in precedenza, rilegge e rivaluta autonomamente... beh fa un certo effetto. Qui trovate la conversazione in italiano e qui in inglese.

Ascoltando tutti

Se poi mettiamo assieme tutti i concetti, tutte le capacità dei vari modelli, la crescita della potenza di calcolo raccontata incessantemente da Jensen Huang, CEO di NVidia, le profezie di Kurzweil di Singularity University e i Jolting Moments di David Orban... otteniamo qualcosa del genere.

Ovvero la possibilità, per chi saprà sfruttare questi strumenti, di evolvere a velocità che prima avrebbero richiesto qualche milione di anni.

Lasciando chiedersi, a chi resta indietro, dove saranno finiti tutti.

Non voglio creare ulteriore FOMO (Fear Of Missing Out, la paura di essere tagliati fuori) con questa crescita esponenziale, ma semplicemente raccontare che questa è la direzione che, ci piaccia o meno, sta prendendo l'umanità. Come raccontato nel post di Alberto Romero c'è un problema di equa distribuzione che già conosciamo e che aumenterà ulteriormente in futuro.

Quindi...

La regola del "Saper fare le domande", per semplificare il concetto di prompting, continua a valere. Attenzione che non significa che un prompt fatto bene in 4o funzioni altrettanto bene in O1 con Deep Research, anzi, sembra proprio il contrario. Ciascun modello ha le sue capacità, limiti, vizi e va esplorato. Ciascun modello richiede tempo e test costanti per verificarne l'efficacia.

E lo stesso meccanismo varrà in molti altri campi. Solo che se lo facciamo come è avvenuto negli ultimi diecimila anni i tempi saranno molto dilatati.

Se siamo costantemente sollecitati e stimolati da modelli di Ai sempre più potenti e veloci abbiamo la possibilità di amplificare di molto e velocemente le nostre capacità, spesso andando oltre la nostra comprensione.

Se ci 'appoggiamo' sulle capacità minime dei modelli AI o di ciò che ci riserverà il futuro, avremo comunque la possibilità di 'migliorare le nostre performance' molto rapidamente, sapendole inoltre utilizzare bene, potremo anche noi amplificarci e forse seguire questa accelerazione sempre più rapida.

Se Daniel Kahneman fosse ancora vivo servirebbe una nuova edizione del suo libro, "Pensieri lenti e veloci". Il nuovo titolo potrebbe essere: "Pensieri lenti, veloci, esponenziali" e potrebbe aiutarci a capire qualcosa di più di questa evoluzione in cui siamo già immersi.

Ah, e nel frattempo dovremmo capire come rimanere umani. Come preservare il nostro pensiero critico, rimanere empatici e decidere in base ai nostri valori, conoscenze, istinti anziché appoggiarci semplicemente su queste curve di crescita spesso inumane? Come dare il giusto livello di agency a questi strumenti rimanendo creativi e mantenendo il controllo?Come distribuire equamente questa Intelligenza Aumentata?

Enjoy AI responsibily!

Massimiliano

Se questo articolo ti è piaciuto condividilo, mi aiuterai a scriverne ancora 😀

Scopri di più su Linkedin o su https://maxturazzini.com

Comments